Материалы по тегу: hugging face

|

29.02.2024 [23:59], Владимир Мироненко

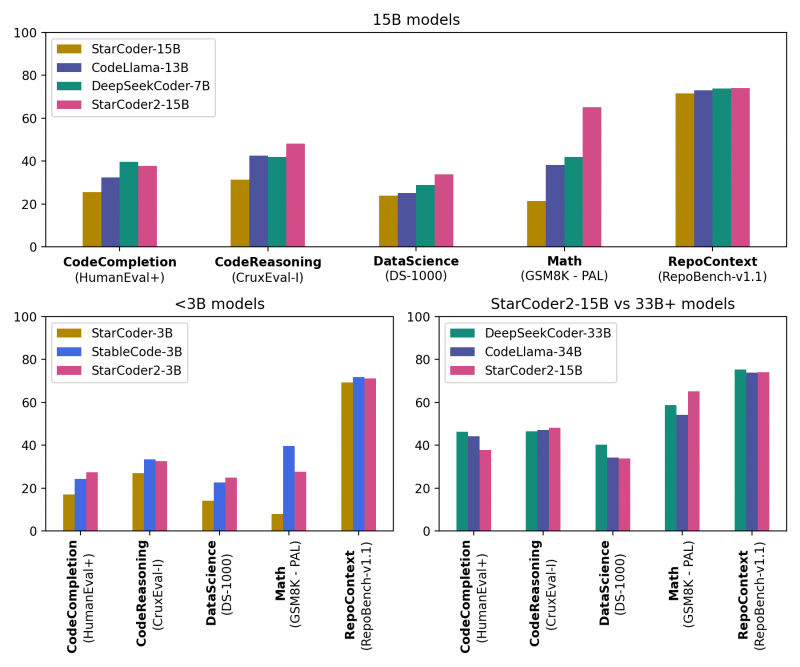

ServiceNow, Hugging Face и NVIDIA представили новое поколение ИИ-моделей StarCoder2 для генерации кодаКомпании ServiceNow, Hugging Face и NVIDIA представили семейство общедоступных больших языковых моделей (LLM) StarCoder2 для генерации кода, призванное помочь разработчикам использовать генеративный ИИ для создания корпоративных приложений. Семейство было разработано NVIDIA в сотрудничестве с исследовательским проектом BigCode, которым управляет ServiceNow, и Hugging Face, разработчиком открытой LLM-платформы. Модели StarCoder2 обучены 619 языкам программирования и могут быть дообучены на собственных данных и встроены в корпоративные приложения для выполнения специализированных задач, таких как генерация кода, управление рабочими процессами, обобщение текста и многое другое. Разработчики могут использовать автодополнение и обобщение кода, извлечение фрагментов кода и другие возможности. Набор StarCoder2 включает три модели: модель с 3 млрд параметров, обученная ServiceNow; модель с 7 млрд параметров, обученная Hugging Face; и модель с 15 млрд параметров, созданная NVIDIA с помощью NVIDIA NeMo. Варианты моделей с меньшим количеством параметров менее требовательны к вычислительной инфраструктуре, при этом модель StarCoder2 с 3 млрд параметров соответствует производительности исходной модели StarCoder с 15 млрд. параметров В основе StarCoder2 лежит новый набор данных Stack v2, который более чем в 7 раз больше, чем Stack v1. Кроме того, новые модели обучены работе с малораспространёнными языками вроде COBOL, «понимают» математику и могут обсуждать исходный код программ. Пользователи могут дообучить и настроить модели StarCoder2, используя данные, специфичные для отрасли или организации, с помощью NVIDIA NeMo или Hugging Face TRL. Разработчики смогут создавать продвинутых чат-ботов для решения более сложных задач обобщения или классификации и разрабатывать персонализированных помощников по программированию. Разработка ПО стала основной областью использования ИИ, чему отчасти способствовали такие инструменты как GitHub Copilot и AWS CodeWhisperer, отметил ресурс SiliconANGLE. Согласно недавнему опросу GitHub, 91 % разработчиков в США используют ИИ-инструменты для создания кода. Впрочем, опрос, проведённый CoderPad Inc., показал, что почти четверть разработчиков скептически относятся к ценности ИИ в работе, а 28 % и вовсе заявили, что их работодатель запрещает им пользоваться ИИ-инструментами. В числе причин негативного отношения — опасения, что ИИ-помощники создают неэффективный или уязвимый код, а также крадут интеллектуальную собственность, генерируя код на основе материалов, защищённых авторским правом, которые использовались при обучении модели. Создатели StarCoder2 подчёркивают, что модели были созданы с использованием данных Software Heritage, крупнейшей, по их словам, общедоступной коллекцию исходных кодов. В целях дальнейшего повышения прозрачности и сотрудничества вспомогательный код модели будет по-прежнему размещаться на странице проекта BigCode на GitHub. Он доступен по лицензии BigCode OpenRAIL-M, обеспечивающей бесплатный доступ и использование. Все модели StarCoder2 также будут доступны для загрузки с Hugging Face, а модель StarCoder2 с 15 млрд параметров доступна в составе NVIDIA AI Foundation.

28.01.2024 [21:40], Сергей Карасёв

Google Cloud и Hugging Face упростят создание и внедрение генеративного ИИКомпании Google и Hugging Face объявили о новом стратегическом партнёрстве, которое позволит разработчикам использовать облачную инфраструктуру Google Cloud для всех сервисов Hugging Face. Инициатива нацелена на ускорение разработки приложений генеративного ИИ и инструментов машинного обучения. По условиям соглашения, Google Cloud становится стратегическим облачным партнёром Hugging Face, предоставляя ресурсы для обучения моделей и инференса. Разработчики смогут использовать ИИ-инфраструктуру Google Cloud, включая CPU, тензорные процессоры (TPU) и GPU, для обучения и обслуживания открытых моделей, а также для создания новых приложений генеративного ИИ. В частности, клиенты получат возможность обучать и настраивать модели Hugging Face с применением Vertex AI — комплексной ИИ-платформы Google Cloud. Разработчики смогут применять фирменные ИИ-ускорители Cloud TPU v5e. В будущем появится поддержка инстансов GCE A3 на базе NVIDIA H100. Говорится о поддержке развёртываний Google Kubernetes Engine (GKE). Для управления и выставления счетов на платформе Hugging Face может использоваться сервис Google Cloud Marketplace.

Источник изображения: pixabay.com Hugging Face, основанная в 2016 году, разрабатывает инструменты для создания приложений с использованием машинного обучения. В частности, она предлагает библиотеку Transformers для работы с ИИ-моделями. Ранее Hugging Face заключила соглашение о сотрудничестве с Dell: стороны помогут корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ.

19.11.2023 [22:52], Сергей Карасёв

Dell и Hugging Face упростят развёртывание генеративного ИИ на базе локальной инфраструктурыКомпании Dell Technologies и Hugging Face объявили о заключении соглашения о сотрудничестве, цель которого заключается в том, чтобы помочь корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ. Партнёры сформируют новый портал на платформе Hugging Face. Через него будут доступны специальные контейнеры и сценарии, которые помогут заказчикам быстро и безопасно разворачивать открытые ИИ-модели, доступные в репозитории Hugging Face. Ранее похожее решение было представлено для моделей Llama 2.

Источник изображения: pixabay.com Для локального развёртывания ИИ-приложений будет использоваться оборудование Dell — серверы PowerEdge и СХД. Со временем на портале появятся дополнительные контейнеры с оптимизированными моделями для инфраструктуры Dell, предназначенные для внедрения ИИ-систем нового поколения. Ранее компания представила расширеннное портфолио комплексных решений и сервисов для «локализации» генеративного ИИ. |

|